ผลิตภัณฑ์ต่างๆ ของ Google พัฒนาขึ้นภายใต้เป้าหมายเดียวกัน นั่นก็คือ เพื่อให้เป็นประโยชน์แก่ผู้ใช้ในทุกช่วงเวลาของชีวิตได้มากที่สุดเท่าที่จะเป็นไปได้

และเราเชื่อมาตลอดว่า ปัญญาประดิษฐ์ หรือ AI (Artificial Intelligence) สามารถช่วยให้เราบรรลุเป้าหมายนี้ได้อย่างมีประสิทธิภาพยิ่งขึ้น

AI ช่วยให้เราเข้าใจภาษาต่างๆ และทำให้ผลการค้นหาเป็นประโยชน์มากยิ่งขึ้นมาตั้งแต่ช่วงแรกๆ ที่ Google Search เปิดให้บริการแล้ว ในช่วงหลายปีที่ผ่านมา เรามีการลงทุนในเทคโนโลยี AI อย่างต่อเนื่อง ทำให้ตอนนี้เราสามารถเข้าใจข้อมูลที่อยู่ในรูปแบบต่างๆ ไม่ว่าจะเป็นภาษา รูปภาพ วิดีโอ หรือแม้แต่สิ่งต่างๆ ที่อยู่รอบตัว

วันนี้ เราจะมาอัปเดตวิธีใหม่ๆ ในการทำให้การค้นหาข้อมูลบน Google Search เป็นธรรมชาติและราบรื่นยิ่งขึ้นด้วยความก้าวหน้าของเทคโนโลยี AI

ค้นหาสิ่งที่คุณเห็น

กล้องเป็นอีกวิธีหนึ่งที่มีประสิทธิภาพในการสำรวจและทำความเข้าใจสิ่งต่างๆ รอบตัว ในแต่ละเดือน มีผู้คนใช้ Google Lens เพื่อค้นหาสิ่งที่เห็นด้วยกล้องหรือรูปภาพมากกว่า 1 หมื่นล้านครั้ง

Google Lens ทำให้คุณเข้าถึงข้อมูลของโลกได้ด้วยรูปภาพ ตอนนี้เรากำลังทำการอัปเดตครั้งสำคัญเพื่อทำให้คุณสามารถค้นหาสิ่งที่อยู่บนหน้าจอมือถือของคุณได้ จากเดิมที่คุณสามารถใช้ Google Lens เพื่อค้นหาข้อมูลด้วยกล้องหรือรูปภาพได้ทันทีจากแถบค้นหา

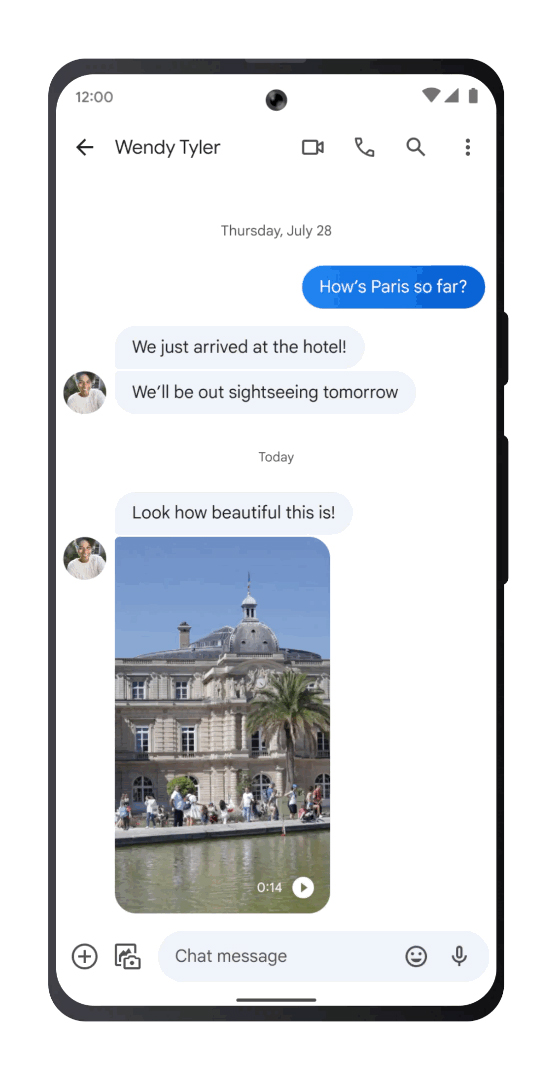

ในอีกไม่กี่เดือนข้างหน้า ผู้ใช้ทั่วโลกจะสามารถใช้ฟีเจอร์ใหม่ใน Google Lens เพื่อ “ค้นหาสิ่งที่อยู่บนหน้าจอ” (search screen) บนอุปกรณ์ Android ได้แล้ว ด้วยเทคโนโลยีนี้ คุณสามารถค้นหาสิ่งที่เห็นในรูปภาพหรือวิดีโอบนเว็บไซต์และแอปต่างๆ ที่คุณชอบได้ เช่น แอปสำหรับการส่งข้อความหรือแอปสำหรับดูวิดีโอ โดยไม่ต้องออกจากแอปนั้นหรือหยุดสิ่งที่กำลังทำอยู่

สมมติว่าเพื่อนของคุณส่งข้อความถึงคุณพร้อมด้วยวิดีโอที่กำลังสำรวจกรุงปารีส หากคุณต้องการเรียนรู้เพิ่มเติมเกี่ยวกับสถานที่สำคัญที่อยู่ในวิดีโอนั้น คุณเพียงแค่กดปุ่มเปิด/ปิดหรือปุ่มโฮมบนโทรศัพท์ Android ของคุณค้างไว้ (ซึ่งเป็นการเรียกใช้ Google Assistant) จากนั้นแตะ “ค้นหาสิ่งที่อยู่บนหน้าจอ” (search screen) เมื่อ Google Lens ระบุว่าสถานที่นั้นคือพระราชวังลุกซ็องบูร์ คุณก็สามารถคลิกเพื่อเรียนรู้เพิ่มเติมได้

ผสมผสานวิธีการค้นหา

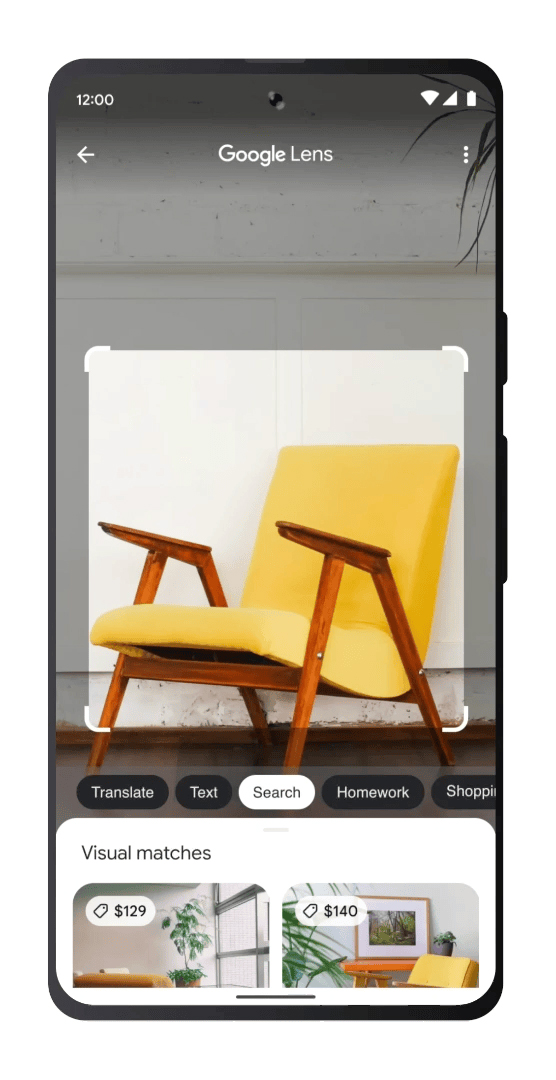

คุณสามารถค้นหาข้อมูลโดยใช้รูปภาพและข้อความไปพร้อมๆ กันได้ด้วยฟีเจอร์มัลติเสิร์ช ซึ่งเป็นการเปิดช่องทางใหม่ๆ ในการแสดงตัวตนของคุณ ปัจจุบัน ฟีเจอร์มัลติเสิร์ชบนอุปกรณ์เคลื่อนที่มีให้บริการทั่วโลกในทุกภาษาและทุกประเทศที่มี Google Lens ให้บริการ

เมื่อไม่นานมานี้ เราได้พัฒนาศักยภาพของฟีเจอร์มัลติเสิร์ชให้ล้ำไปอีกขั้นโดยการเพิ่มความสามารถในการค้นหาสิ่งที่อยู่ในละแวกใกล้เคียง โดยคุณสามารถถ่ายรูปและเพิ่มคำว่า “ใกล้ฉัน” (near me) เพื่อค้นหาสิ่งที่คุณต้องการได้ ไม่ว่าจะเป็นการหาร้านค้าที่อยู่ในละแวกใกล้เคียงหรือการหาบางอย่างในเวลาที่เร่งรีบ ปัจจุบัน ฟีเจอร์นี้มีให้บริการเป็นภาษาอังกฤษในสหรัฐอเมริกา และในอีกไม่กี่เดือนข้างหน้า เราจะขยายฟีเจอร์นี้ไปทั่วโลก

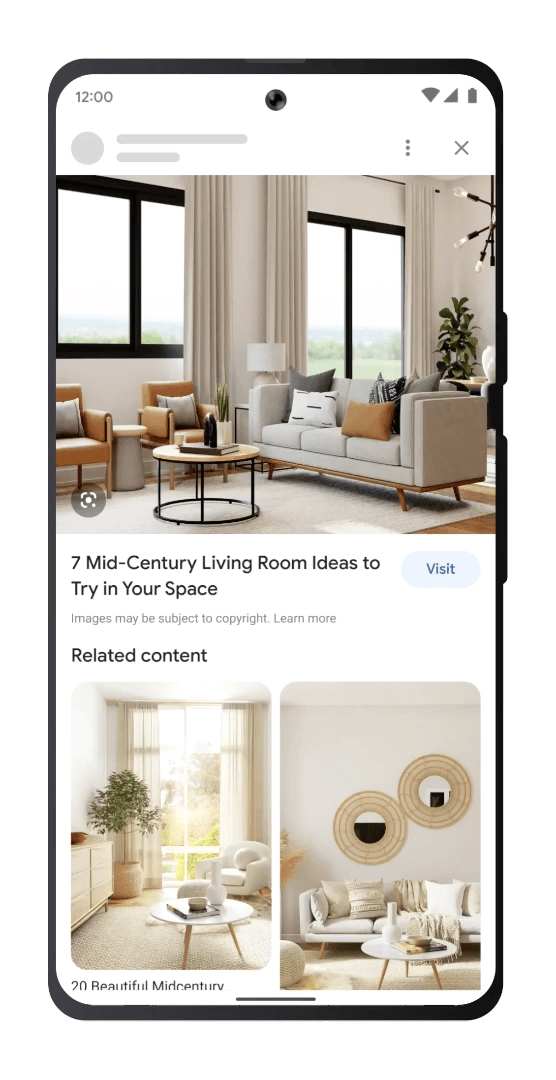

และบางครั้งคุณอาจค้นหาเมื่อคุณเห็นสิ่งที่น่าสนใจและสร้างแรงบันดาลใจให้คุณอยู่แล้ว ในอีกไม่กี่เดือนข้างหน้า คุณและผู้ใช้ทั่วโลกจะสามารถใช้ฟีเจอร์มัลติเสิร์ชกับทุกรูปภาพที่เห็นในหน้าผลการค้นหาบนอุปกรณ์เคลื่อนที่ได้แล้ว

ตัวอย่างเช่น คุณอาจกำลังค้นหา “ไอเดียการตกแต่งห้องนั่งเล่นสไตล์โมเดิร์น” และเห็นโต๊ะกาแฟที่ชอบ แต่อยากได้แบบที่เป็นทรงกลมแทนทรงสี่เหลี่ยมผืนผ้า คุณก็สามารถใช้ฟีเจอร์มัลติเสิร์ช แล้วเพิ่มคำว่า “สี่เหลี่ยมผืนผ้า” ลงไป เพื่อค้นหาโต๊ะที่คุณต้องการได้

เรากำลังสร้างประสบการณ์การค้นหาที่เป็นธรรมชาติและช่วยให้เห็นภาพมากขึ้น แต่นี่เป็นเพียงแค่จุดเริ่มต้นเท่านั้น และด้วยพลังของ AI ยังมีความเป็นไปได้อีกมากมายรอเราอยู่ในอนาคต